Markkinoiden johtava toimitusketjun ja vähittäiskaupan suunnitteluratkaisu

Autamme jälleenmyyjiä ja kuluttajabrändejä yhtenäistämään suunnitteluprosessinsa, kysynnän ennustamisesta ja vähittäismyynnistä toimitusketjun ja kaupan toimintojen optimointiin.

Pitkäaikaisia kumppanuuksia

Mitä on RELEX

RELEXin ratkaisuiden avulla asiakkaamme optimoivat suunnitteluprosessejaan ennennäkemättömällä tarkkuudella. Toimitusketjujen, tilanhallinnan, täydennysprosessien, alennusten ja työvoiman optimointi onnistuu yhdellä kokonaisvaltaisella ennusteisiin pohjautuvalla järjestelmällä.

30%

vähemmän varastoa

99+%

parempi saatavuus

40%

vähemmän pilaantuneita tuoretuotteita

8%

vähemmän henkilöstökustannuksia

Maksimoi asiakastyytyväisyys ja minimoi operatiiviset kustannukset RELEXin avulla

Johtavat jälleenmyyjät ja kuluttajabrändit käyttävät RELEXiä parantaakseen tuotteiden saatavuutta, kasvattaakseen myyntiä, ja saadakseen parhaan mahdollisen tuoton varastolle, tilalle, työvoimalle sekä kapasiteetille.

Edistä kasvua ja toiminnan tehokkuutta parantamalla tuotteiden saatavuutta sekä tekemällä parempia vähittäismyyntipäätöksiä kaikissa myynti- ja jakelukanavissasi.

Ennakoi ja vastaa kysyntään kaikissa kanavissa maksimaalisella palvelutasolla sekä tehokkaalla varaston, kapasiteetin ja työvoiman käytölla.

Maksimoi kysynnän suunnittelun tarkkuus kasvattaaksesi myyntiä, raaka-aineiden saatavuutta sekä varaston ja tuotantokapasiteetin tehokasta käyttöä.

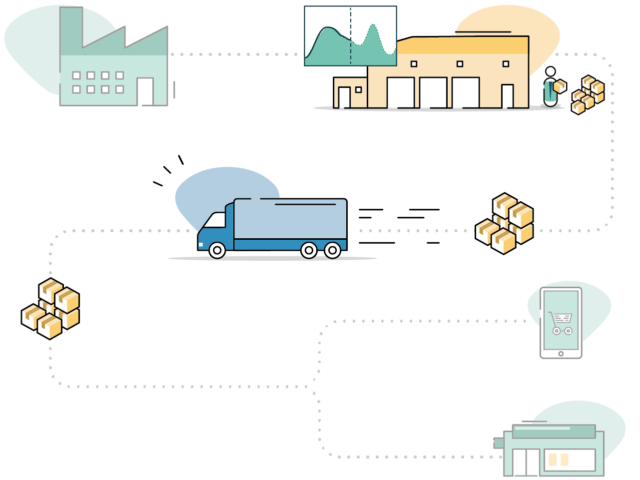

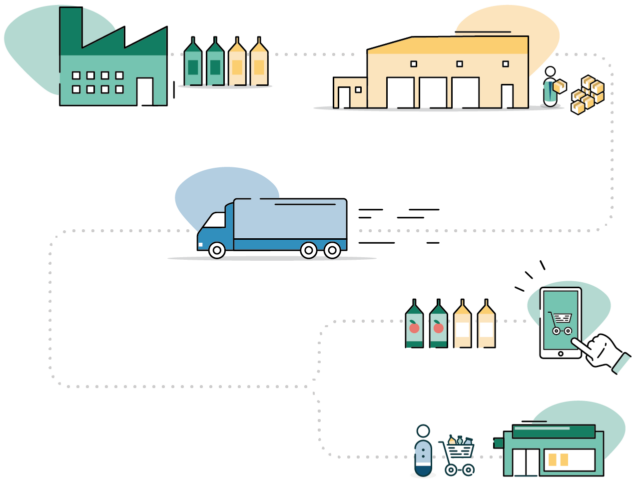

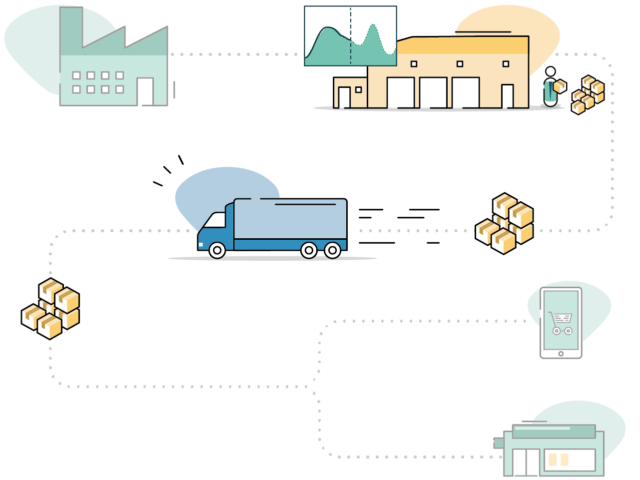

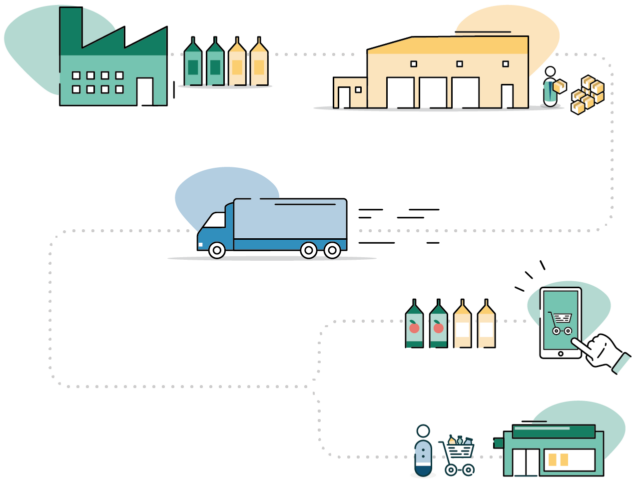

Hyödynnä monitasoista optimointia, tiedon jakamista ja yhteistyötä lisätäksesi näkyvyyttä ja mukautumiskykyä koko arvoketjussasi.

Kokonaisvaltaiset ratkaisut auttamaan sinua

Johtavat jälleenmyyjät ja kuluttajabrändit käyttävät RELEXiä parantaakseen tuotteiden saatavuutta, kasvattaakseen myyntiä, ja saadakseen parhaan mahdollisen tuoton varastolle, tilalle, työvoimalle sekä kapasiteetille.

Kysynnän suunnittelu

Koneoppimisen avulla näet satojen kysyntätekijöiden vaikutuksen tarkkoina kysynnän ennusteina, kehittäen suunnitteluprosesseja kaikilla kaupan ja toimitusketjujen ydinosa-alueilla.

Vähittäismyynti

Maksimoi myyntisi ja katteesi RELEXin kategorianhallinnan ja kaupan toimintojen optimoinnin ratkaisuilla.

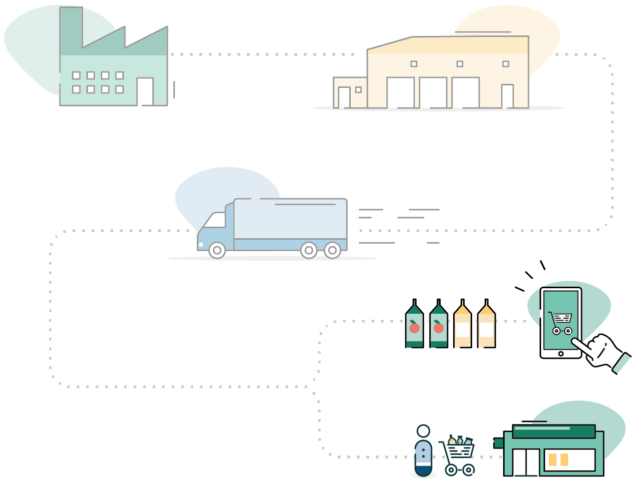

Toimitusketju

Saavuta maksimaalinen saatavuus minimaalisilla kustannuksilla RELEXin E2E-toimitusketjuratkaisuilla.

Kaupan toiminnot

Optimoi prosessisi varaston, kapasiteetin ja resurssien järkevällä käytöllä.

Kokonaisvaltainen opas toimitusketjun muutokseen

Toimitusketjujen ja niihin liittyvän liiketoiminnan muuttaminen ja nykyaikaistaminen ei sisällä vain uuden tehokkaan tekniikan käyttöönottoa, vaan myös prosessien ja organisaation arviointia.

Tämä opas tukee sinua valitessasi ja käyttöönottaessasi sinun liiketoiminnallesi oikeaa toimitusketjujen hallinnan ratkaisua.

Uutiset

Viimeisimmät uutiset RELEXiltä

RELEX Solutions vahvistaa toimitusketjun hallinnan ratkaisujaan valmistavalle teollisuudelle ostamalla ruotsalaisen Optimityn

Yritysosto laajentaa RELEX Solutionsin tarjoamaa tuotannonsuunnitteluun, jotta kulutustuotteiden valmistajat voivat tehdä kysynnän, jakelun, tuotannon ja hankinnan suunnittelua yhden ratkaisun avulla.

RELEX Solutions on nimetty johtajaksi vähittäiskaupan suunnittelun analyytikkoraportissa

Forrester Research, johtava maailmanlaajuinen tutkimusyhtiö, on nimennyt RELEXin “johtajaksi” Forrester Wave™: Retail Planning Platforms, Q4 2023-raportissaan.

Onnistuneen Suomen STARK-yhteistyön myötä RELEX Solutions optimoi Ruotsissa lähes 120 myymälän toimintoja

Ruotsin johtava rakentajien ja remontoijien rautakauppaketju Beijer Byggmaterial optimoi toimitusketjunsa hallintaa ja tehokkuutta RELEXin kysynnän ennuste- ja täydennysratkaisun avulla. Tämä parantaa tuotteiden saatavuutta yhtiön yritys- ja yksityisasiakkaille.

Paikallinen tiimimme

RELEX on kansainvälinen, mutta suomalainen yritys. Pääkonttorimme sijaitsee Suomessa, jossa kehitämme jatkuvasti tuotteitamme paremmaksi ja olemme aina lähellä asiakkaitamme.

Tiimimme Helsingissä on valmis keskustelemaan tarpeistasi ja tavoitteistasi, sekä selvittämään, kuinka ratkaisumme voisivat tuottaa lisäarvoa yrityksellesi.

RELEX Suomi

RELEX Solutions

Postintaival 7

00230 Helsinki

info@relexsolutions.com