Ganzheitliche und effiziente Supply-Chain-Planung durch Big Data

Apr 19, 2018 • 4 min

Nach wie vor ist Big Data ist eines der großen Schlagwörter der Branche. Gemeinhin beschreibt der Begriff riesige Datenmengen mit verschiedenen Strukturen aus unterschiedlichen Quellen, die von diversen Prozessen und Nutzern erzeugt und an einem Ort zusammengeführt werden. Uneinigkeit besteht darüber, ob die Verarbeitungsmöglichkeit der Datenmengen mit zur Definition gehört. So oder so: Ohne ein System zur intelligenten Analyse sind riesige Datenvolumina zwar speicherbar, können aber nicht verarbeitet werden und sind damit nutzlos.

Die in der Logistik erzeugten Datenmengen steigen ständig und Prozesse werden komplexer. Jeder Datenpunkt bedeutet Interaktion und liefert wichtige Informationen: Ein Artikel wird aus dem Regal genommen oder eingeräumt, ein defektes oder abgelaufenes Produkt wird abgeschrieben, ein Kunde schaut sich Artikel auf einer Website an. An jeder Position in der Supply-Chain entstehen neue Daten oder es werden Daten geändert. Bis vor Kurzem konnten die meisten Händler diese punktuellen Daten in ihrer Gänze weder sammeln, speichern, noch verarbeiten. Deshalb wird ihre Bedeutung heute noch oft verkannt.

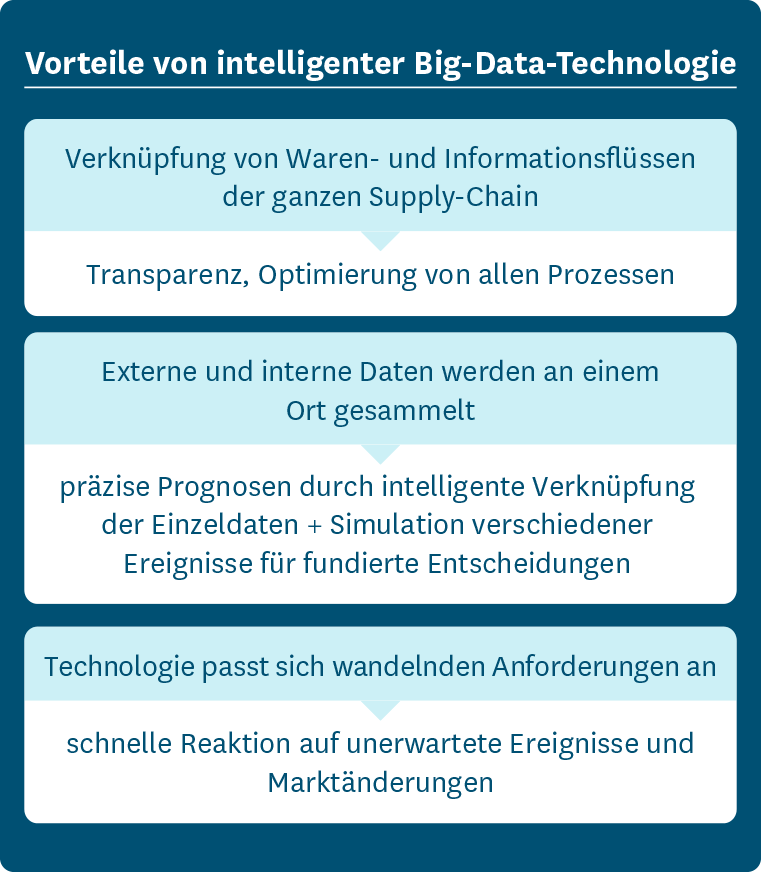

Dabei bietet Big Data Händlern einzigartige Chancen auf dem hart umkämpften Markt. Über die ganze Lieferkette hinweg vernetzte und analysierte Waren- und Informationsflüsse verschaffen klare Wettbewerbsvorteile: Transparenz, die Möglichkeit Ereignisse zu simulieren, bevor Entscheidungen getroffen werden, und schnelle Reaktionen auf Veränderungen. Ohne Transparenz wird die Supply-Chain nur im jeweiligen Silo optimiert. Denn jeder kann nur den Bereich verbessern, in den er Einblick hat – also den eigenen. Allerdings liegen über 70 Prozent des Optimierungspotenzials in einem ganzheitlichen Ansatz.

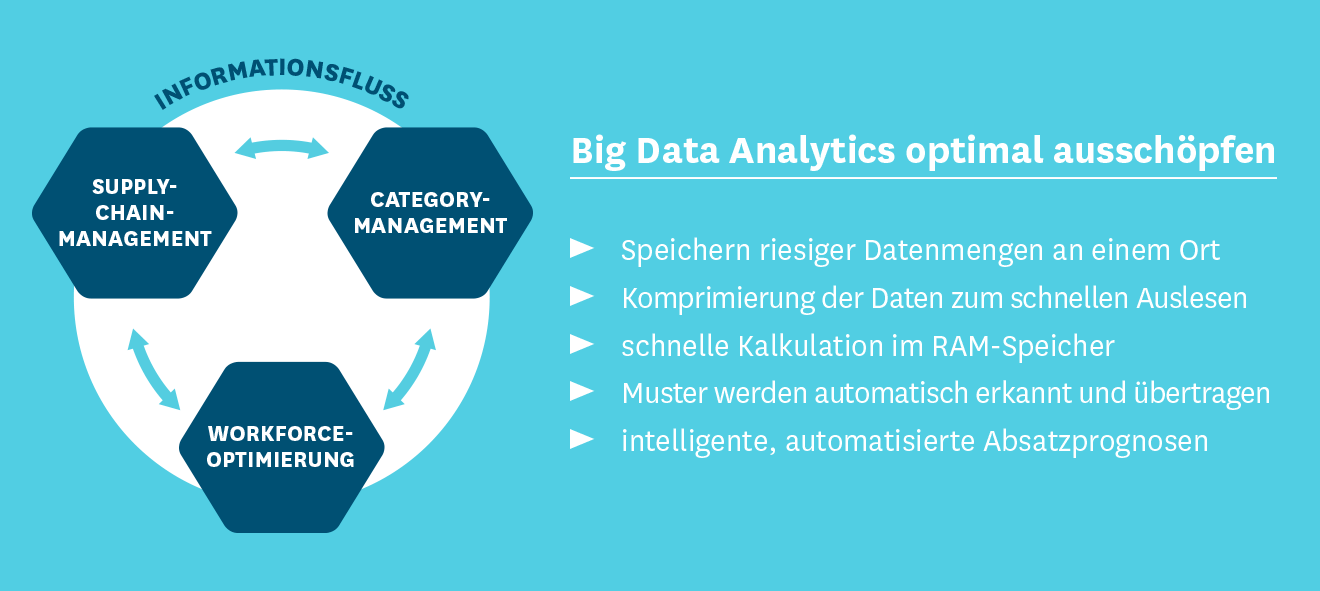

Big-Data-Technologie stellt jedoch immer komplexere Anforderungen an IT-Systeme. Diese werden den Bedarfen oft nicht mehr gerecht. Ein klassisches ERP-System kann meistens nicht oder nur unzureichend mit externen Partnern vernetzt werden. Das führt dazu, dass wichtige Daten fehlen oder nicht zu jedem Zeitpunkt verfügbar sind. Im Durchschnitt sind nur 20 Prozent aller Supply-Chain-Daten im eigenen System gespeichert. Meist sind dies interne Daten wie Informationen über Aufträge des eigenen Unternehmens, Produktionspläne, Bestand und Abverkäufe. Ein ganzheitlicher Blick auf die Supply-Chain benötigt jedoch auch externe Daten, wie Lieferfähigkeit und Zuverlässigkeit von Lieferanten. Ist zum Beispiel bekannt, welche Artikel wie oft und wie schnell geliefert werden, so kann der Platz im Lager optimal ausgeschöpft werden. Das spart Zeit und Geld.

Nicht nur die großen Einzelhandelsketten mit mehreren Lagern und mehrstufigen Prozessen profitieren von Big-Data-Analysen: Auch kleine und mittelständische Unternehmen steigern durch intelligente und automatisierte Prognosen die Effizienz ihrer Lieferkette. So erlaubt die Erfassung der historischen Lieferdauer Rückschlüsse auf künftige Lieferzeiten. Das rentiert sich besonders in Zeiten mit hohem Versandaufkommen. Sind alle Partner vernetzt, erfassen moderne IT-Systeme, wenn sich eine Lieferung verzögert oder ein Produkt über den Stammlieferanten nicht lieferbar ist. Dann bestellt die Software das fehlende Produkt automatisch bei einem hinterlegten Ersatzlieferanten. Das vermeidet Out-of-Stocks. Natürlich bestimmen aber alle Beteiligten selbst, wer Einblick in welche Daten erhält.

Die Technologie zur Big-Data-Analyse vereinigt externe und interne Daten und sammelt sie an einem Ort. Dies erfolgt in zwei Hauptschritten:

Zuerst werden die Daten aus verschiedenen Quellen durch Verknüpfung strukturiert und Trends aufgedeckt. So werden sie beherrschbar und bedarfsgerecht zur Verfügung gestellt. Danach erfolgt die tiefergehende Datenanalyse, die die präzise Erstellung von Prognosen ermöglicht. Diese beziehen eine Vielzahl an Faktoren mit ein: historische Absatzdaten, Mindesthaltbarkeit, saisonale Schwankungen, Wettervorhersagen und Events. „Was-wenn“-Szenarien simulieren die Effekte diverser Entscheidungen, bevor sie getroffen werden. Sie ermöglichen eine langfristige Planung und fundierte Entscheidungen. Gleichzeitig bilden sie auch kurzfristige Ereignisse ab und ermöglichen schnelle Aktion schon bevor das prognostizierte Ereignis, zum Beispiel eine Out-of-Stock-Situation, eintritt. Auch wählen gute IT-Systeme mit Big-Data-Analysen für jeden Artikel automatisch aus verschiedenen Prognosemethoden die ideale aus.

Das Rückgrat jeder guten Big-Data-Lösung bildet eine spaltenorientierte Datenbank. Sie komprimiert Daten effektiver und effizienter als herkömmliche zeilenorientierte. Das spart nicht nur Speicherplatz – Daten werden auch um ein Vielfaches schneller ausgelesen als aus klassischen Datenbanken. Ist die spaltenorientierte Datenbank darüber hinaus In-Memory-fähig, spart sie zusätzlich Zeit: Da die Daten bei Kalkulationen im RAM-Speicher des Computers verbleiben, entfällt der langwierige Transfer auf die Festplatte und zurück. Dank dieser Faktoren berechnet moderne Big-Data-Software Bestellvorschläge für 50 Mio. Produktstandorten in etwa zwei Stunden. Das ist 100-mal schneller als bei herkömmlichen Lösungen. Zusätzlich sollte die Software fähig sein, aus Beispielen zu lernen und diese zu verallgemeinern. Hier kommt das Schlagwort „Machine-Learning“ ins Spiel: Das System erkennt Muster und Gesetzmäßigkeiten und kann so auch unbekannte Daten beurteilen und dadurch Entscheidungen treffen oder vor Fehlern warnen. Machine-Learning-basierte Prognosen neigen jedoch bisweilen zu Überanpassung. Sie sollten daher immer mit anderen Prognosemodellen verglichen werden. Gute Software warnt dabei automatisch vor starker Abweichung und schlägt geeignetere Prognosen vor.

Supply-Chain-Verantwortliche müssen mit Big Data arbeiten, um langfristig wettbewerbsfähig zu bleiben. Es reicht jedoch nicht, nur den Speicherplatz für große Datenmengen zu Verfügung zu stellen – auch ausreichend Rechenleistung und die richtige Analyse-Technologie sind nötig. Komplexität und Größe der Datenmengen werden weiter steigen. Eine moderne Big-Data-Lösung passt sich daher an Änderungen des Marktes und des Unternehmens an und optimiert die Supply-Chain vom Lieferanten über die Lager bis in den PoS hinein. Nur so verleiht sie einen ganzheitlichen Überblick über die Supply-Chain und optimiert diese auf allen Ebenen.